起因

自从 Deepseek 爆火之后。大量的普通群众接触到了 AIGC 这一从未接触的领域,确实提高了部分工作的效率。但是同时也带来了一些问题。

部分人 仿佛把 Deepseek 当成了仅有的 外置大脑。自己不会思考答案的合理性和正确性。

我在b站视频的评论区看到很多评论,他们把评论区争议的问题丢给AI,然后AI受到包括但不限于 提示词/刻意引导/AI幻觉/错误数据集 等种种因素的影响,给出一个并不完全准确/具有一定倾向性的答案,他们把答案贴在评论区,仿佛是一个尚方宝剑。

无论谁质疑。只需要回应说这是 Deepseek 生成的,就像拥有了一个免死金牌,答案就一定是正确的,谁都无法辩驳的。

AI的回答可以相信吗?

如果你使用过大量的AI产品,你都会发现基本上所有的AI产品的回答下都会告诉你 AI回答的内容可能不准确 。他们都有一个共同点——都会产生 AI幻觉(AI hallucination) 。  ChatGPT

ChatGPT  Qwen

Qwen

什么是AI幻觉?

AI幻觉(AI hallucination) 指模型生成与事实不符、逻辑断裂或脱离上下文的内容,本质是统计概率驱动的“合理猜测”,用人话说就是 瞎几把乱扯,胡编数据和事实

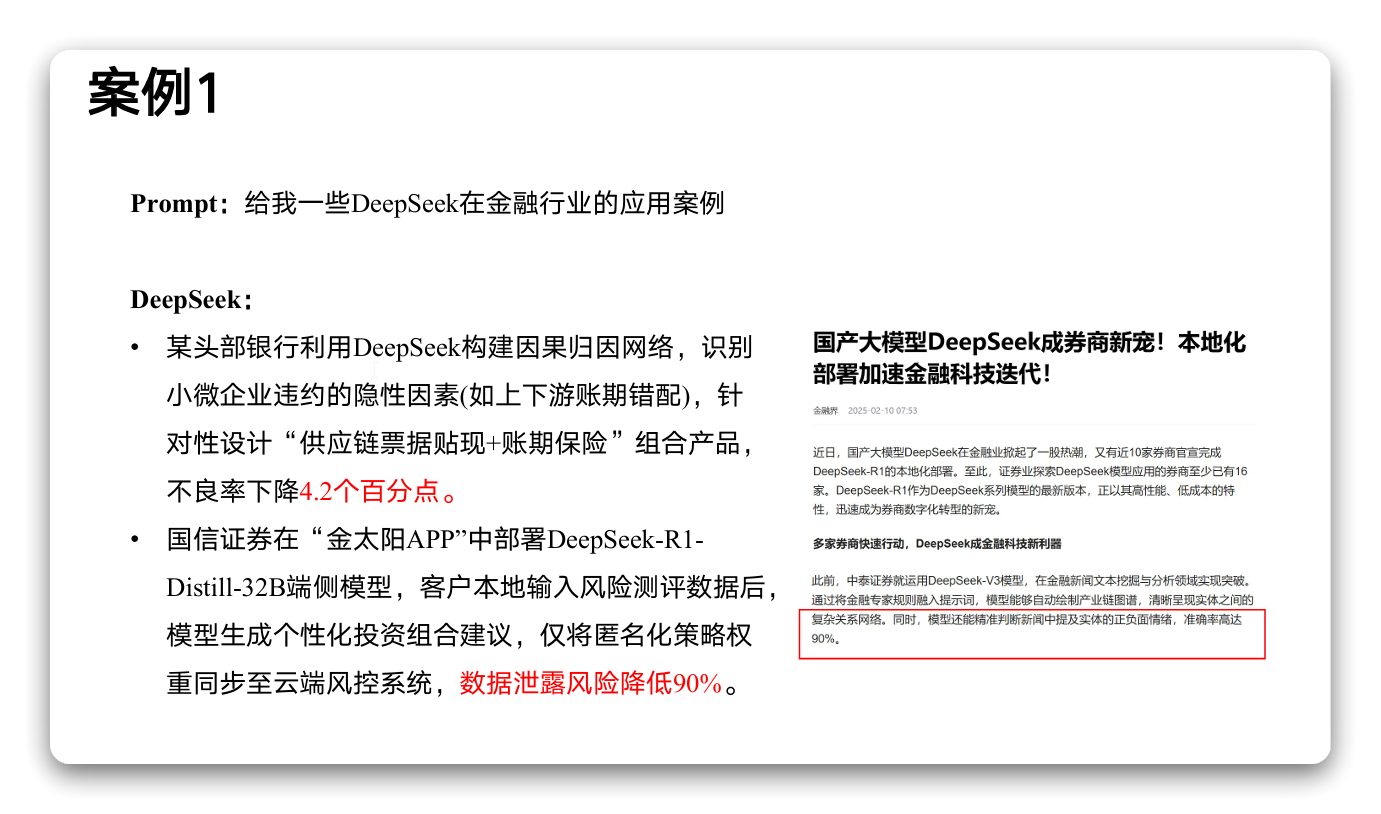

事实上,当前主流生成式AI基于transformer架构,通过注意力机制构建知识关联网络。所以目前的语言大模型避免不了 AI幻觉(AI hallucination) 的产生。  案例一

案例一 案例二

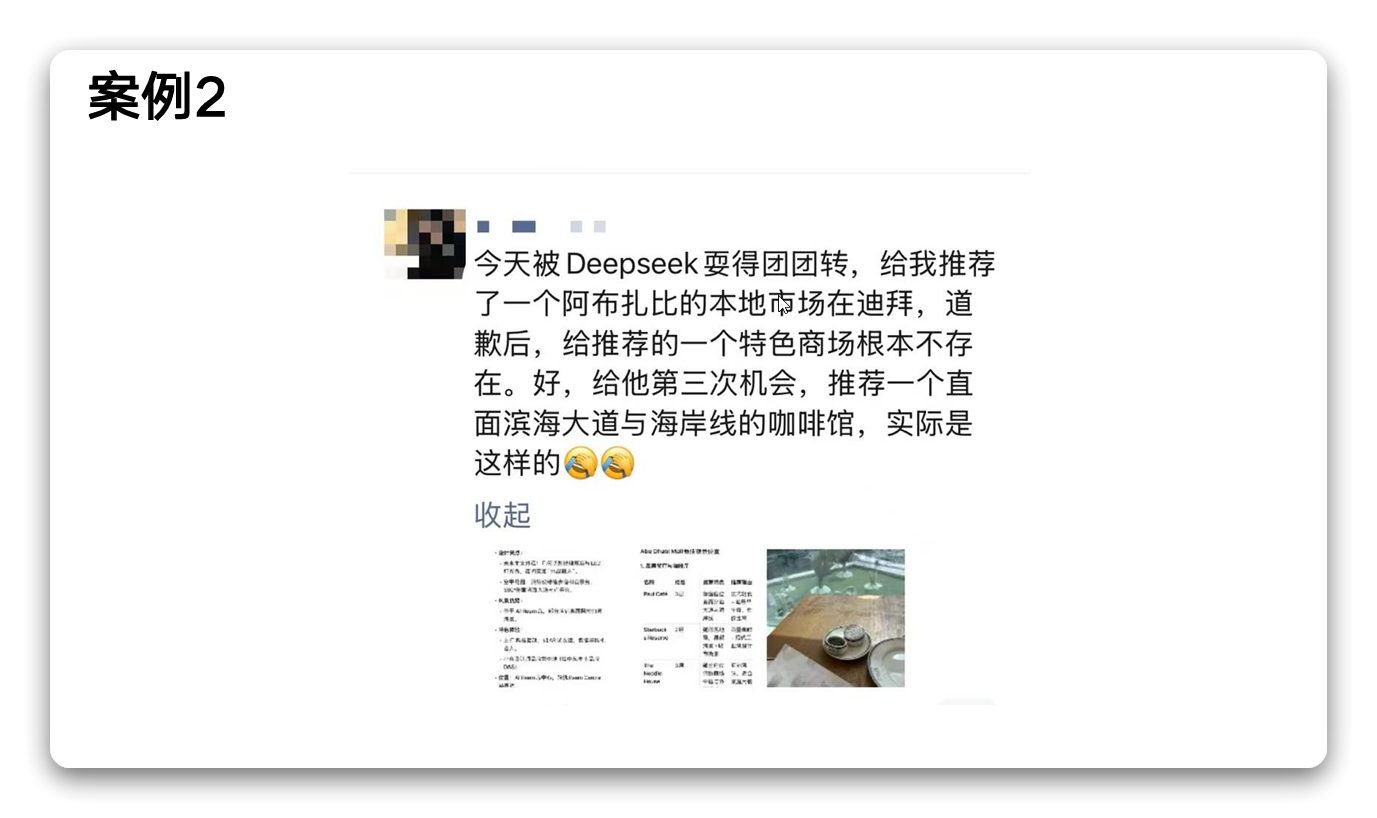

案例二

为什么会出现AI幻觉?

AI 幻觉最常见的表现就是会编造一些不存在的事实或者细节。

就像在考试时遇到不会的题目,我们会试图用已知的知识去推测答案一样。AI 在遇到信息缺失或不确定的情况时,会基于自己的 经验(训练数据)进行填补和推理。

这不是因为它想要欺骗我们,而是因为它在试图用自己理解的模式来完成这个任务。

基于统计关系的预测

因为 大语言模型(LLM) 通过大量的训练数据学习文字之间的统计关系。它的核心目标是根据上下文预测最可能出现的下一个词,并不是对问题或内容进行真正的理解。所以 AI 本质上是通过概率最大化来生成内容,而不是通过逻辑推理来生成内容的。

简单来说, AI 就像是一个博览群书的智者,通过学习海量的文本和资料来获取知识。但是它并不是真正理解这些知识,而是通过找到文字之间的统计关系和模式来 预测 下一个最合适的词。即 AI 是根据之前学到的大量例子,来猜测接下来最有可能出现的词。

不过有时候,模型也会 猜错 。如果前面出现一点偏差,后面的内容就会像滚雪球一样越滚越大。这就是为什么 AI 有时会从一个小错误开始,最后编织出一个完全虚构的故事。

训练数据的局限性

由于 AI 并没有真实世界的体验,它的所有“认知”都来自训练数据。可是训练数据不可能包含世界上所有的信息,有时候甚至还会包含错误信息。这就像是一个人只能根据自己读过的书来回答问题,如果书里有错误信息,或者某些领域的知识缺失,就容易产生错误的判断。

有限的上下文窗口

受限于成本以及技术原因。它们是在一个有限的范围内理解文本。这就像是隔着一个小窗口看书,这个小窗口可能是128K,可能是64K,看不到整本书的内容,容易产生理解偏差。

示例 :

用户第一次问:“爱因斯坦提出了什么理论?”

AI:爱因斯坦提出了相对论。

用户第二次问:“谁提出了相对论?”

AI:牛顿提出了相对论。(因为上下文窗口限制,模型未能关联两次提问)

综上所述:AI生成的结果是不可信的,并且AI幻觉仍然是大语言模型有待解决的一大难题。

那么Deepseek怎么样?

根据 HHEM (Vectara公司发布的AI幻觉测试榜单,在业内具有一定的权威性)的数据。Deepseek的幻觉率达到了14.3%。

这个幻觉率什么水平呢?我们来看其他的知名模型

| 模型名称 | 幻觉率 |

|---|---|

| GPT-4o | 1.5% |

| o1-mini | 1.4% |

| o1 | 2.4% |

| o3-mini-higu-reasoning | 0.8% |

| Gemini-2.0-Flash-Exp | 1.3% |

| Gemini-2.0-Flash-Thinking-Exp | 1.8% |

| Gemini-2.0-Pro-Exp | 0.8% |

| Claude-3.7-Sonnet | 4.4% |

| DeepSeek-V3 | 3.9% |

| DeepSeek-R1 | 14.3% |

我自己的实际使用也印证了这一数据。给deepseek发一段报错日志,他会更改代码之后,自己幻想更改之后可能的输出并告诉我已经测试好了,完成逻辑自洽以证明自己更改正确。

所以,在使用Deepseek的时候,更要对生成的答案采取质疑的态度

同样还有一个很有趣的观点 不代表笔者观点,仅供参考

不代表笔者观点,仅供参考

如何才能降低 AI 幻觉?

作为普通用户,我们有没有办法减少幻觉呢?

这里可以推荐观看这个文章——当AI变“聪明”了,提问的姿势也要变! 当AI变“聪明”了,提问的姿势也要变!

当AI变“聪明”了,提问的姿势也要变!

同样的可以看这个——如何减少AI幻觉

一、优化提问

想要获得准确答案,提问方式很关键。

与 AI 交流也需要明确和具体,避免模糊或开放性的问题,提问越具体、清晰,AI 的回答越准确。同时,我们在提问的时候要提供足够多的上下文或背景信息,这样也可以减少AI胡乱推测的可能性。总结成提示词技巧就> 是下面四种问法:

设定边界:“请严格限定在 2022 年《自然》期刊发表的研究范围内”;示例:“介绍 ChatGPT 的发展历程” → “请仅基于 OpenAI 官方 2022-2023 年的公开文档,介绍 ChatGPT 的发展历程”

标注不确定:“对于模糊信息,需要标注‘此处为推测内容’”;示例:“分析特斯拉 2025 年的市场份额” → “分析特斯拉 2025 年的市场份额,对于非官方数据或预测性内容,请标注[推测内容]”

步骤拆解:“第一步列举确定的事实依据,第二步展开详细分析”;示例:“评估人工智能对就业的影响” → “请分两步评估 AI 对就业的影响:1) 先列出目前已发生的具体影响案例;2) 基于这些案例进行未来趋势> 分析”。

明确约束:明确告诉 AI 要基于已有事实回答,不要进行推测。示例:“预测 2024 年房地产市场走势” → “请仅基于 2023 年的实际房地产数据和已出台的相关政策进行分析,不要加入任何推测性内容”。

二、分批输出

因为 AI 内容是根据概率来进行生成的,一次性生成的内容越多,出现 AI 幻觉的概率就越大,我们可以主动限制它的输出数量。比如:如果我要写一篇长文章,就会这么跟 AI 说:“咱们一段一段来写,先把开头写好。> 等这部分满意了,再继续写下一段。”这样不仅内容更准确,也更容易把控生成内容的质量。

三、交叉验证

想要提高 AI 回答的可靠性,还有一个实用的方法是采用“多模型交叉验证”。使用的一个 AI 聚合平台:可以让多个 AI 模型同时回答同一个问题。当遇到需要严谨答案的问题时,就会启动这个功能,让不同的大模型一> 起参与讨论,通过对比它们的答案来获得更全面的认识。

RAG技术

AI 是一个聪明但健忘的人,为了让他表现更靠谱,我们可以给他配一个超级百科全书,他可以随时查阅里面的内容来回答问题。这本“百科全书”就是 RAG 的核心,它让 AI 在回答问题之前,先从可靠的资料中找到相关> 信息,再根据这些信息生成答案。这样一来,AI 就不容易“胡说八道”了。目前 RAG 技术多用在医疗、法律、金融等专业领域,通过构建知识库来提升回答的准确性。当然实际使用中像医疗、法律、金融这样的高风险领> 域,AI 生成的内容还是必须要经过专业人士的审查的。

总结

由Deepseek-R1生成

AI正在重塑知识生产方式,但它仍是概率引擎而非认知主体。正如望远镜需要校准才能准确观测星空,AI工具也需要人类的审慎使用和持续验证。期待未来的技术突破能降低幻觉率,但在那之前,保持批判性思维仍是我们驾驭AI的核心竞争力。

正如计算机科学家Donald Knuth所言:"人工智能已经能通过图灵测试,但距离通过图灵审计还有很长的路要走。"